활성화 함수: Difference between revisions

From IT Wiki

No edit summary |

No edit summary |

||

| (2 intermediate revisions by the same user not shown) | |||

| Line 1: | Line 1: | ||

[[분류:인공지능]] | [[분류:인공지능]] | ||

;Activation Function | ;Activation Function | ||

;[[인공 신경망]] 모델에서 입력값으로 받은 데이터를 다음 층으로 어떻게 출력할지를 결정하는 함수 | |||

== 종류 == | == 종류 == | ||

{| class="wikitable" | |||

* [[ | ! 구분 | ||

* [[ | ! 명칭 | ||

! 그래프 | |||

! 설명 | |||

|- | |||

| rowspan="3" | 단극성 | |||

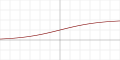

| Sigmoid | |||

| [[파일:활성화함수-시그모이드.png]] | |||

| 로지스틱 함수. x값을 변화에 따라 0~출력 | |||

|- | |||

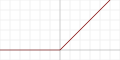

| ReLU | |||

| [[파일:활성화함수-렐루.png]] | |||

| x값이 음수일 땐 0 고정 | |||

|- | |||

| Softmax | |||

| 2차원 그래프로 표현 불가 | |||

| 여러 입력값을 0~1로 나누어 표현 | |||

|- | |||

| rowspan="3" | 양극성 | |||

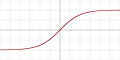

| tanh | |||

| [[파일:활성화함수-하이퍼볼릭탄젠트.png]] | |||

| Sigmod보다 기울기가 크며 1~1 범위를 가짐 | |||

|- | |||

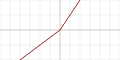

| LReLU | |||

| [[파일:활성화함수-리키렐루.png]] | |||

| 음수일 때 입력값의 1/10 출력 | |||

|- | |||

| Maxout | |||

| 2차원 그래프로 표현 불가 | |||

| 두 개의 W와 b중에서 큰 값 사용 | |||

|} | |||

== 같이 보기 == | |||

* [[인공 신경망]] | |||

* [[퍼셉트론]] | |||

Latest revision as of 23:23, 26 October 2019

- Activation Function

- 인공 신경망 모델에서 입력값으로 받은 데이터를 다음 층으로 어떻게 출력할지를 결정하는 함수