민감도: Difference between revisions

From IT Wiki

No edit summary |

No edit summary |

||

| Line 31: | Line 31: | ||

* [[혼동 행렬]] | * [[혼동 행렬]] | ||

* [[F1 스코어]] | * [[F1 스코어]] | ||

== 각주 == | |||

Latest revision as of 03:45, 21 October 2024

Sensitivity; Recall; TPR

데이터 과학에서 민감도는 주로 분류 모델의 성능을 평가할 때 사용되는 지표 중 하나로, 참 양성 비율(True Positive Rate, TPR)을 나타낸다. 즉, 실제로 양성(Positive)인 데이터를 모델이 얼마나 잘 찾아내는지를 의미한다.

공식[edit | edit source]

Sensitivity = True Positive[TP] / (True Positive[TP] + False Negative[FN])

계산 예시

- 참 양성 / 참 양성 + 거짓 음성

- 예를 들어 100명 중 10명이 양성으로 진단 되었는데

- 10명 중 8명은 실제 양성이었고(참 양성), 2명은 음성인데 잘못 판단된 것이다(거짓 양성).

- 그리고 나머지 90명은 음성이 나왔는데 그 중 양성이 5명이 있었다(거짓 음성).

- 여기서 거짓 양성은 쓰이질 않는다. 음성인데 양성으로 잘못 판단된 것은 이 지표에서 중요하지 않다. (아래 활용 챕터 참고)

- 8 / 8 + 5 = 8 / 13 = 약 0.62

- 실제 13명의 환자 중 62%만 발견 해낼 수 있었단 것이다.

활용[edit | edit source]

이 지표는 특히 의료 분야와 같이 양성 사례(예: 질병이 있는 환자)를 놓치는 것이 중요한 분야에서 매우 유용하다. Sensitivity가 높을수록 모델은 실제 양성인 사례를 더 많이 찾아내며, False Negative(실제 양성인데 음성으로 잘못 분류된 경우)[1]의 비율이 낮아진다.

예를 들어, 암을 진단하는 모델에서는 암 환자를 놓치지 않고 모두 발견하는 것이 중요하기 때문에 높은 Sensitivity가 요구된다.

Sensitivity는 때때로 Recall이라고도 불리며, Precision과 함께 모델의 성능을 종합적으로 평가하는 데 사용되는 F1 Score 계산에도 활용된다.

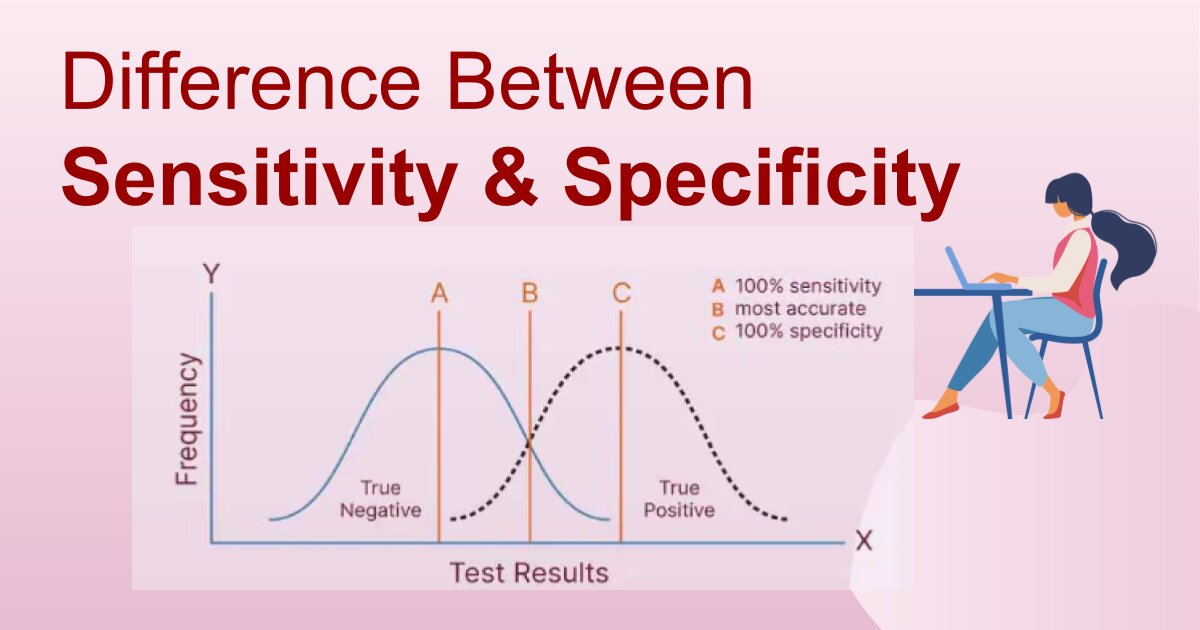

Specificity와의 차이[edit | edit source]

같이 보기[edit | edit source]

각주[edit | edit source]

- ↑ 의료 분야에서는 질병에 안 걸렸는데 질병에 걸렸다고 하는 것 보다 질병에 걸렸는데 질병에 안 걸렸다고 하는 것이 훨씬 더 심각한 문제이기 때문이다.