적대적 공격: 두 판 사이의 차이

IT위키

(새 문서: 딥 러닝의 심층 신경망을 이용한 모델에 적대적 교란(Adversarial Pertubation)을 적용하여 오분류를 유발하고 신뢰도 감소를 야기하는 머신...) |

편집 요약 없음 |

||

| 1번째 줄: | 1번째 줄: | ||

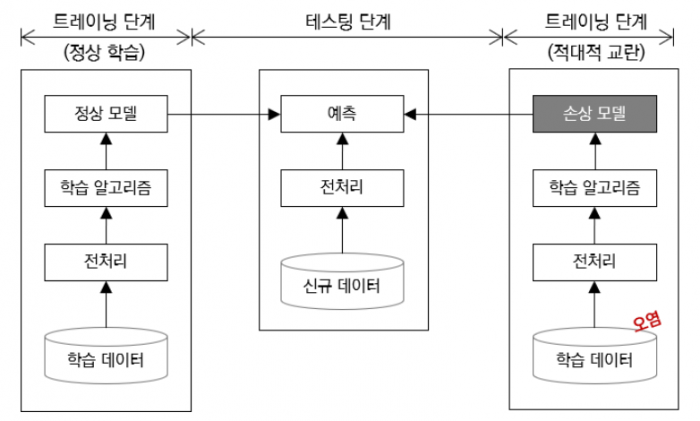

[[딥 러닝]]의 심층 신경망을 이용한 모델에 적대적 교란(Adversarial Pertubation)을 적용하여 오분류를 유발하고 신뢰도 감소를 야기하는 머신러닝 공격 기법 | [[딥 러닝]]의 심층 신경망을 이용한 모델에 적대적 교란(Adversarial Pertubation)을 적용하여 오분류를 유발하고 신뢰도 감소를 야기하는 머신러닝 공격 기법 | ||

* AI 모델의 역기능 효과를 유발하여 AI 산업 및 서비스 응용 분야 활성화의 저해 요인으로 작용 | *AI 모델의 역기능 효과를 유발하여 AI 산업 및 서비스 응용 분야 활성화의 저해 요인으로 작용 | ||

[[파일:적대적 공격 개념도.png|700x700픽셀]] | [[파일:적대적 공격 개념도.png|700x700픽셀]] | ||

== 적대적 공격 유형 == | ==적대적 공격 유형== | ||

{| class="wikitable" | {| class="wikitable" | ||

!유형 | !유형 | ||

!설명 | !설명 | ||

|- | |- | ||

|회피 공격 (Evasion Attack) | |회피 공격 | ||

(Evasion Attack) | |||

| | | | ||

* 인간의 눈으로 식별하기 어려운 노이즈 데이터를 삽입하여 변조 | *인간의 눈으로 식별하기 어려운 노이즈 데이터를 삽입하여 변조 | ||

* 사례 : 정지 표시 표지판을 속도 제한 표시로 잘못 인식하여 자율 주행 자동차의 오작동을 유발([[적대적 스티커]]) | *사례 : 정지 표시 표지판을 속도 제한 표시로 잘못 인식하여 자율 주행 자동차의 오작동을 유발([[적대적 스티커]]) | ||

|- | |- | ||

|중독 공격 (Poisoning Attack) | |중독 공격 | ||

(Poisoning Attack) | |||

| | | | ||

* 데이터셋에 악성 데이터를 삽입하는 것과 같이 AI 모델의 학습 과정에 관여하여 AI 시스템 자체를 손상시키는 공격 | *데이터셋에 악성 데이터를 삽입하는 것과 같이 AI 모델의 학습 과정에 관여하여 AI 시스템 자체를 손상시키는 공격 | ||

* 사례 : MS의 인공지능 채팅봇 테이(Tay)가 극우자들의 악의적인 공격에 노출되어 욕설, 인종차별 발언을 남발하여 운영 16 시간만에 중단 | *사례 : MS의 인공지능 채팅봇 테이(Tay)가 극우자들의 악의적인 공격에 노출되어 욕설, 인종차별 발언을 남발하여 운영 16 시간만에 중단 | ||

|- | |- | ||

|탐색적 공격 (Exploratory Attack) | |탐색적 공격 | ||

(Exploratory Attack) | |||

| | | | ||

* AI 모델의 주어진 입력에 대해 출력되는 분류 결과와 신뢰도(Confidence)를 분석하여 역으로 데이터를 추출 | *AI 모델의 주어진 입력에 대해 출력되는 분류 결과와 신뢰도(Confidence)를 분석하여 역으로 데이터를 추출 | ||

* 공개된 API 가 존재하는 학습모델의 정보를 추출하여 기능적으로 유사한 모델을 구현할 수 있는 블랙-박스 공격(Black-Box Attacks) | *공개된 API 가 존재하는 학습모델의 정보를 추출하여 기능적으로 유사한 모델을 구현할 수 있는 블랙-박스 공격(Black-Box Attacks) | ||

|} | |} | ||

== 대응 방안 == | ==대응 방안== | ||

{| class="wikitable" | {| class="wikitable" | ||

!구분 | !구분 | ||

| 33번째 줄: | 36번째 줄: | ||

|예방 | |예방 | ||

| | | | ||

* (적대적 훈련) 머신러닝 훈련 단계에서 예상 가능한 적대적 사례 데이터를 충분히 입력하여 저항성을 향상 | *(적대적 훈련) 머신러닝 훈련 단계에서 예상 가능한 적대적 사례 데이터를 충분히 입력하여 저항성을 향상 | ||

* 사례 : Defense-GAN | *사례 : Defense-GAN | ||

|- | |- | ||

|탐지 | |탐지 | ||

| | | | ||

* 원래의 모델과 별도로 적대적 공격 여부를 판단하기 위한 모델을 추가하여 결과값을 비교 | *원래의 모델과 별도로 적대적 공격 여부를 판단하기 위한 모델을 추가하여 결과값을 비교 | ||

|- | |- | ||

|차단 | |차단 | ||

| | | | ||

* 반복적 쿼리 조회 또는 공개된 API 의 실행 횟수 제한 | *반복적 쿼리 조회 또는 공개된 API 의 실행 횟수 제한 | ||

|- | |- | ||

|은닉 | |은닉 | ||

| | | | ||

* 결과값이 노출되지 않도록 처리 | *결과값이 노출되지 않도록 처리 | ||

* 분석이 불가능 하도록 암호화 또는 비식별 처리 | *분석이 불가능 하도록 암호화 또는 비식별 처리 | ||

|} | |} | ||

== 같이 보기 == | ==같이 보기== | ||

* [[머신러닝]] | *[[머신러닝]] | ||

* [[적대적 스티커]] | *[[적대적 스티커]] | ||

* [[인공지능 보안]] | *[[인공지능 보안]] | ||

== 참고 문헌 == | ==참고 문헌== | ||

* 정보관리기술사 123회 하나둘셋 동기회 기출풀이집 | *정보관리기술사 123회 하나둘셋 동기회 기출풀이집 | ||

[[분류:인공지능]] | [[분류:인공지능]] | ||

[[분류:보안 공격]] | [[분류:보안 공격]] | ||

2021년 8월 3일 (화) 17:04 기준 최신판

딥 러닝의 심층 신경망을 이용한 모델에 적대적 교란(Adversarial Pertubation)을 적용하여 오분류를 유발하고 신뢰도 감소를 야기하는 머신러닝 공격 기법

- AI 모델의 역기능 효과를 유발하여 AI 산업 및 서비스 응용 분야 활성화의 저해 요인으로 작용

적대적 공격 유형[편집 | 원본 편집]

| 유형 | 설명 |

|---|---|

| 회피 공격

(Evasion Attack) |

|

| 중독 공격

(Poisoning Attack) |

|

| 탐색적 공격

(Exploratory Attack) |

|

대응 방안[편집 | 원본 편집]

| 구분 | 대응 방안 |

|---|---|

| 예방 |

|

| 탐지 |

|

| 차단 |

|

| 은닉 |

|

같이 보기[편집 | 원본 편집]

참고 문헌[편집 | 원본 편집]

- 정보관리기술사 123회 하나둘셋 동기회 기출풀이집