강화 학습: 두 판 사이의 차이

IT 위키

(새 문서: 분류:인공지능 ;Reinforcement learning ;머신러닝의 학습 모델로, 현재 상태에서 어떤 행동(Action)을 하면 가장 보상(Reward)를 많이 받을 지...) |

편집 요약 없음 |

||

| 3번째 줄: | 3번째 줄: | ||

;[[머신러닝]]의 학습 모델로, 현재 상태에서 어떤 행동(Action)을 하면 가장 보상(Reward)를 많이 받을 지 스스로 학습하는 모델 | ;[[머신러닝]]의 학습 모델로, 현재 상태에서 어떤 행동(Action)을 하면 가장 보상(Reward)를 많이 받을 지 스스로 학습하는 모델 | ||

* 행동 심리학을 기반으로 고안됨 | * 행동 심리학을 기반으로 고안됨 | ||

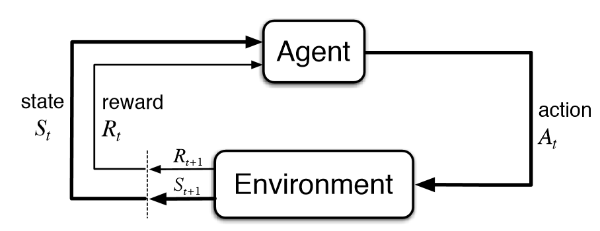

[[파일:강화 학습.png]] | |||

== 특징 == | |||

* 보상 기반: 행동 심리학 기반, 보상을 통한 행동 유도 | |||

* 목표 지향: 구체적으로 정해진 목표 수행 의도 | |||

* 상호 작용: 데이터가 아닌 반복 수행 및 피드백을 통한 습득 | |||

== 종류 == | |||

=== 마르코프 결정 프로세스 === | |||

;MDP; Markov Decision Process | |||

* 특징 | |||

** Stochastic: 다음 결과는 확률적으로 결정됨 | |||

** Partially Observable: 전체 결정 과정을 조망할 수 없음 | |||

* 구성 | |||

** S: 상태들의 유한 집합 | |||

** A: 행동들의 유한 집합 | |||

** Policy = ㅠ(s) -> S | |||

2019년 10월 28일 (월) 21:34 판

- Reinforcement learning

- 머신러닝의 학습 모델로, 현재 상태에서 어떤 행동(Action)을 하면 가장 보상(Reward)를 많이 받을 지 스스로 학습하는 모델

- 행동 심리학을 기반으로 고안됨

특징

- 보상 기반: 행동 심리학 기반, 보상을 통한 행동 유도

- 목표 지향: 구체적으로 정해진 목표 수행 의도

- 상호 작용: 데이터가 아닌 반복 수행 및 피드백을 통한 습득

종류

마르코프 결정 프로세스

- MDP; Markov Decision Process

- 특징

- Stochastic: 다음 결과는 확률적으로 결정됨

- Partially Observable: 전체 결정 과정을 조망할 수 없음

- 구성

- S: 상태들의 유한 집합

- A: 행동들의 유한 집합

- Policy = ㅠ(s) -> S