에너지 기반 모델: 두 판 사이의 차이

IT 위키

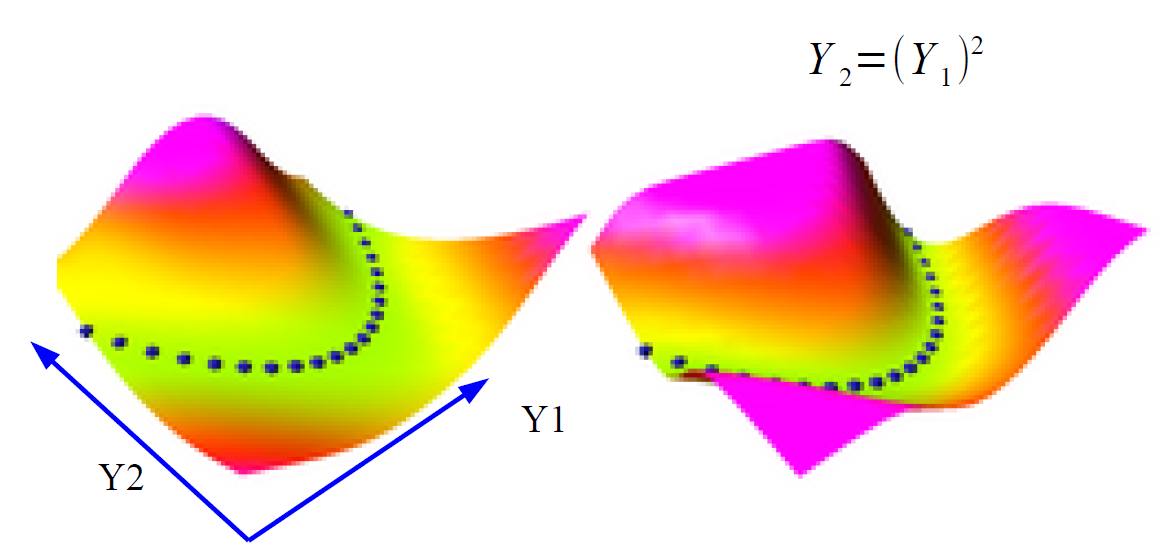

(새 문서: 섬네일|에너지 기반 모델 학습 과정 개념도 에너지 기반 모델(Energy-Based Model, EBM)은 입력과 출력 구성(configuration)에 대해 스칼라 에너지 함수를 정의하고, 낮은 에너지를 갖는 구성일수록 더 가능성 있는 상태로 간주하는 기계 학습 모델이다. ==개념== *EBM은 통계 물리학의 개념을 차용하여, 가능한 구성들에 대해 에너지...) |

편집 요약 없음 |

||

| (같은 사용자의 중간 판 하나는 보이지 않습니다) | |||

| 7번째 줄: | 7번째 줄: | ||

*확률은 종종 볼츠만 분포 형태로 간접적으로 표현되며, 에너지가 낮을수록 더 높은 확률로 간주된다. | *확률은 종종 볼츠만 분포 형태로 간접적으로 표현되며, 에너지가 낮을수록 더 높은 확률로 간주된다. | ||

==학습 방법== | ==학습 방법== | ||

[[파일:에너지 기반 모델 학습 과정 예시.gif]] | |||

EBM 학습에서 가장 큰 도전은 정규화 상수를 직접 계산하기 어렵다는 점이다. 이로 인해 최대우도법을 직접 적용하기 어려우며, 대신 근사적 방법이 사용된다. | EBM 학습에서 가장 큰 도전은 정규화 상수를 직접 계산하기 어렵다는 점이다. 이로 인해 최대우도법을 직접 적용하기 어려우며, 대신 근사적 방법이 사용된다. | ||

*로그 가능도의 기울기는 에너지 함수의 기울기와 모델 분포에서의 기대값 차이로 나타난다. | *로그 가능도의 기울기는 에너지 함수의 기울기와 모델 분포에서의 기대값 차이로 나타난다. | ||

2025년 10월 2일 (목) 07:15 기준 최신판

에너지 기반 모델(Energy-Based Model, EBM)은 입력과 출력 구성(configuration)에 대해 스칼라 에너지 함수를 정의하고, 낮은 에너지를 갖는 구성일수록 더 가능성 있는 상태로 간주하는 기계 학습 모델이다.

개념[편집 | 원본 편집]

- EBM은 통계 물리학의 개념을 차용하여, 가능한 구성들에 대해 에너지 값을 부여하는 방식으로 확률 분포를 간접적으로 모델링한다.

- 주어진 구성 (x) 또는 (x, y) 쌍에 대해 에너지 함수 E(x) 또는 E(x, y)를 정의한다. 에너지가 낮은 구성은 더 그럴듯한 상태로 해석한다.

- 직접 확률 분포를 명시적으로 모델링하지 않고, 정규화 상수(partition function)가 알려지지 않은 형태의 비정규화 확률 모델로 다룬다.

- 확률은 종종 볼츠만 분포 형태로 간접적으로 표현되며, 에너지가 낮을수록 더 높은 확률로 간주된다.

학습 방법[편집 | 원본 편집]

EBM 학습에서 가장 큰 도전은 정규화 상수를 직접 계산하기 어렵다는 점이다. 이로 인해 최대우도법을 직접 적용하기 어려우며, 대신 근사적 방법이 사용된다.

- 로그 가능도의 기울기는 에너지 함수의 기울기와 모델 분포에서의 기대값 차이로 나타난다.

- 모델 분포에서의 기대값을 계산하기 위해 샘플링 기법이 필요하며, 마코프 연쇄 몬테카를로(MCMC), Langevin Dynamics 등의 방법이 널리 사용된다.

- 매 학습 반복 시 모델에서 샘플을 생성하고, 실제 데이터와 비교하여 파라미터를 업데이트하는 과정을 반복한다.

장점[편집 | 원본 편집]

- 복잡하고 다봉우리(multi-modal) 구조의 확률 분포를 유연하게 모델링할 수 있다.

- 단일 에너지 함수로 전체 모델을 구성할 수 있어 구조가 단순하다.

- 생성, 복원, 분류 등 다양한 작업에 활용될 수 있는 범용성 있는 프레임워크다.

- 확률적 모델과 판별 모델의 경계를 넘나드는 유연한 적용이 가능하다.

한계[편집 | 원본 편집]

- 정규화 상수 계산이 어려워 학습이 간접적이고 비효율적일 수 있다.

- MCMC 기반 샘플링의 계산 비용이 높고, 수렴이 느리거나 불안정할 수 있다.

- 학습 도중 모드 붕괴, 비효율적 샘플링 등으로 인해 품질 저하 가능성이 존재한다.

- 고차원 데이터나 대규모 모델에서 적용이 어렵거나 매우 느릴 수 있다.

응용 및 확장[편집 | 원본 편집]

- 볼츠만 머신(Boltzmann Machine), 제한 볼츠만 머신(RBM) 등은 EBM의 고전적 형태이다.

- Joint EBM은 입력과 레이블의 결합 분포를 에너지 기반으로 모델링한다.

- Energy-Based GAN(EBGAN)은 판별기를 에너지 함수로 해석하며, GAN의 변형 구조로 제안되었다.

- Transformer 기반 언어 모델에서도 EBM 개념이 적용된 사례가 있다. 예: ELECTRIC.

같이 보기[편집 | 원본 편집]

참고 문헌[편집 | 원본 편집]

- Xie, J., Lu, Y., Zhu, S.C., Wu, Y.N., "A Theory of Generative ConvNet", ICML 2016.

- Zhao, J., Mathieu, M., LeCun, Y., "Energy-Based Generative Adversarial Network", arXiv preprint arXiv:1609.03126.

- Du, Y., Mordatch, I., "Implicit Generation and Generalization in Energy-Based Models", arXiv preprint arXiv:1903.08689.

- Liu, J., Li, C., Li, T., Zhu, J., "Learning Energy-Based Models with Langevin Dynamics", NeurIPS 2017.