추측 디코딩: 두 판 사이의 차이

편집 요약 없음 |

편집 요약 없음 |

||

| 24번째 줄: | 24번째 줄: | ||

*vLLM 엔진에서는 가이드·추측 디코딩(guide & speculative decoding)으로 구현되어 있다. | *vLLM 엔진에서는 가이드·추측 디코딩(guide & speculative decoding)으로 구현되어 있다. | ||

*NVIDIA의 TensorRT-LLM 프레임워크에서는 추론 지연을 줄이기 위한 주요 기법으로 채택되었다. | *NVIDIA의 TensorRT-LLM 프레임워크에서는 추론 지연을 줄이기 위한 주요 기법으로 채택되었다. | ||

*Medusa 프로젝트에서는 여러 디코딩 헤드를 추가하여 동시에 여러 단계의 토큰을 제안하는 구조를 도입하였다. | *[[Medusa (인공지능)|'''Medusa''']] 프로젝트에서는 여러 디코딩 헤드를 추가하여 동시에 여러 단계의 토큰을 제안하는 구조를 도입하였다. | ||

==한계 및 연구 과제== | ==한계 및 연구 과제== | ||

*초안 모델과 대상 모델의 정렬을 어떻게 최적화할지에 대한 연구가 필요하다. | *초안 모델과 대상 모델의 정렬을 어떻게 최적화할지에 대한 연구가 필요하다. | ||

2025년 11월 13일 (목) 05:11 기준 최신판

추측 디코딩(영어: Speculative Decoding)은 거대 언어 모델(LLM)의 자동회귀 디코딩 과정에서 지연(latency)과 처리량(throughput)을 개선하기 위해 고안된 방법으로, 작은 초안 모델이 여러 개의 미래 토큰을 제안하고, 이후 고성능 대상 모델이 이를 병렬로 검증하는 방식이다.

개요[편집 | 원본 편집]

기존의 자동회귀 디코딩 방식은 한 번에 하나의 토큰을 생성하고 그 결과를 기다려야 다음 단계를 진행할 수 있었다. 이 때문에 특히 대형 모델의 경우 처리 지연이 길어지는 문제가 발생하였다. 추측 디코딩은 이러한 병목을 완화하기 위해 다음과 같은 구조를 가진다.

- 초안 단계: 작은 모델이 입력 문맥을 바탕으로 여러 개의 다음 토큰 후보를 빠르게 생성한다.

- 검증 단계: 대상 모델이 후보 토큰들을 병렬로 평가하여, 실제로 모델이 생성할 가능성이 높은 토큰만을 수락한다.

이 과정을 통해 순차적인 토큰 생성이 아닌 병렬 검증 기반의 구조로 바뀌어 디코딩 지연이 줄고 처리량이 향상된다.

작동 원리[편집 | 원본 편집]

드래프팅 단계[편집 | 원본 편집]

초안 모델은 대상 모델보다 작거나 간소화된 형태로, 현재까지의 접두사(prefix)를 입력으로 다음 K개의 토큰 후보를 생성한다. 이 모델은 보통 대상 모델을 모방하거나 지식 증류(knowledge distillation)를 통해 훈련된다.

검증 단계[편집 | 원본 편집]

생성된 후보 토큰들은 대상 모델의 단일 포워드 패스(forward pass)를 통해 평가된다. 대상 모델은 각 후보 위치에서 확률 분포를 계산하고, 초안 모델이 제안한 토큰이 높은 확률을 갖는다면 해당 토큰을 수락한다. 첫 번째로 수락되지 않은 후보가 나오면 그 이후의 후보는 모두 버리고 접두사부터 다시 생성한다.

수락률과 효율성[편집 | 원본 편집]

수락률(acceptance rate)이 높을수록 초안 모델의 예측이 대상 모델과 일치하므로 병렬 처리 효율이 커진다. 반대로 수락률이 낮으면 재생성이 많아져 오히려 효율이 떨어질 수 있다.

장점[편집 | 원본 편집]

- 순차적 생성 대신 여러 토큰을 한 번에 검증할 수 있어 지연(latency)이 줄어든다.

- 동일한 하드웨어에서 처리량(throughput)을 높일 수 있다.

- 메모리 대역폭이 병목인 환경에서 성능 향상이 크다.

단점[편집 | 원본 편집]

- 초안 모델이 대상 모델과 다르게 예측하면 수락률이 낮아져 효율이 떨어진다.

- 검증 단계에서 대상 모델의 추가 연산이 필요해 오버헤드가 생길 수 있다.

- 품질 유지가 중요하므로 수락 임계값이나 모델 정렬 등의 튜닝이 필요하다.

응용[편집 | 원본 편집]

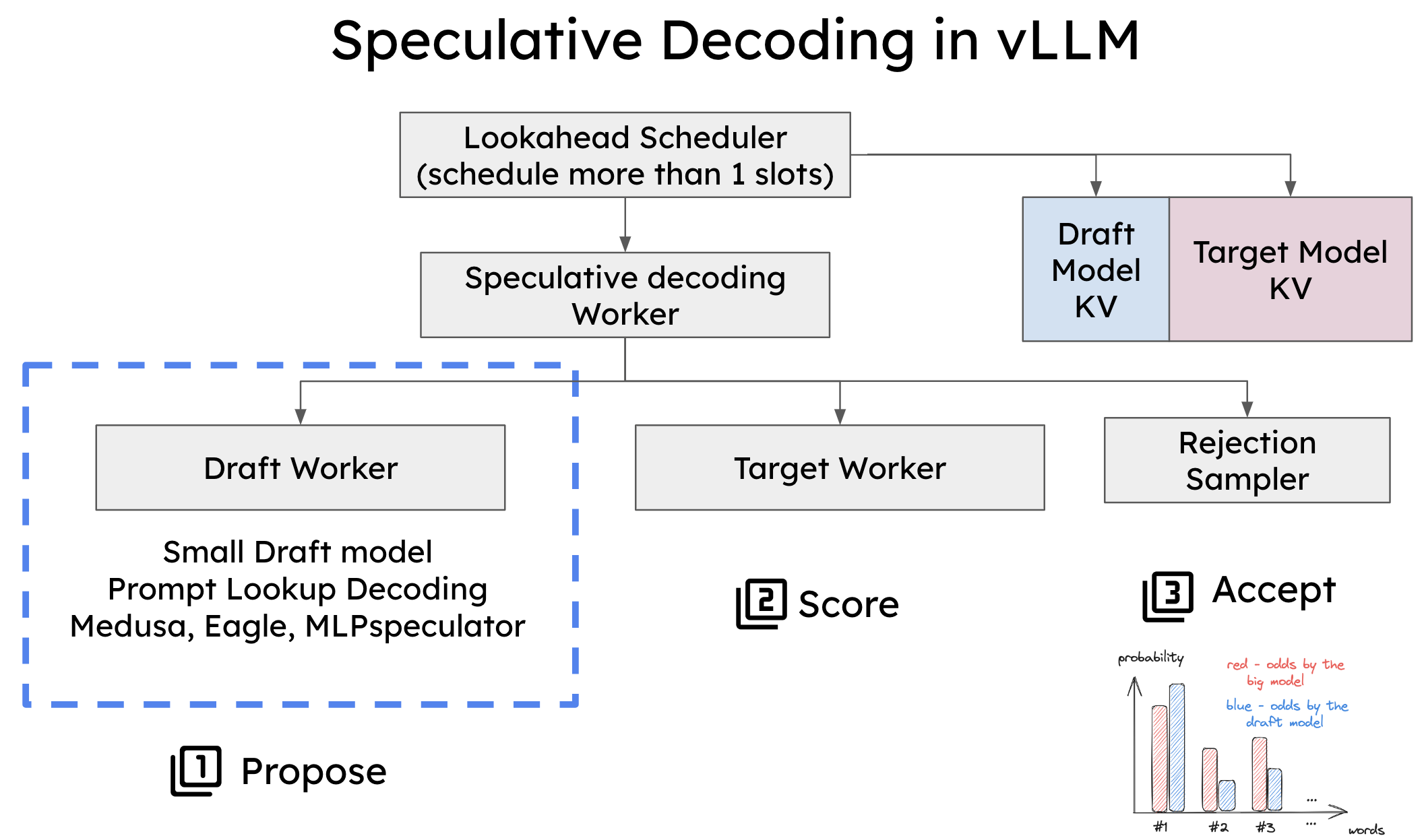

- vLLM 엔진에서는 가이드·추측 디코딩(guide & speculative decoding)으로 구현되어 있다.

- NVIDIA의 TensorRT-LLM 프레임워크에서는 추론 지연을 줄이기 위한 주요 기법으로 채택되었다.

- Medusa 프로젝트에서는 여러 디코딩 헤드를 추가하여 동시에 여러 단계의 토큰을 제안하는 구조를 도입하였다.

한계 및 연구 과제[편집 | 원본 편집]

- 초안 모델과 대상 모델의 정렬을 어떻게 최적화할지에 대한 연구가 필요하다.

- 수락 임계값과 후보 토큰 길이(K)의 선택이 성능에 큰 영향을 미친다.

- 실제 서비스 환경에서는 입력 길이와 생성 길이에 따라 성능 편차가 존재한다.

- 블록 병렬 디코딩(blockwise decoding), 청크 프리필(chunk prefill) 등과의 결합 가능성이 연구되고 있다.

용어 정리[편집 | 원본 편집]

- 대상 모델(target model): 최종 출력 품질을 담당하는 고성능 언어 모델

- 초안 모델(draft model): 대상 모델보다 작고 빠르며 후보 토큰을 제안하는 모델

- 수락률(acceptance rate): 초안 모델의 제안 중 대상 모델이 수락한 비율

- 접두사(prefix): 현재까지 생성된 토큰 시퀀스로, 다음 토큰 생성을 위한 맥락

같이 보기[편집 | 원본 편집]

참고 문헌[편집 | 원본 편집]

- Li, Jamie. "An Introduction to Speculative Decoding for Reducing Latency in AI Inference." NVIDIA Developer Blog, 2025년 9월 19일.

- Aleksa Gordić. "vLLM Internals: High-Throughput LLM Inference System." RosettaLens, 2025년 9월 2일.

- A Comprehensive Survey of Speculative Decoding. 2024.