BERT: 두 판 사이의 차이

IT 위키

편집 요약 없음 |

편집 요약 없음 |

||

| 3번째 줄: | 3번째 줄: | ||

;[[자연어 처리]] 언어 모델 | ;[[자연어 처리]] 언어 모델 | ||

[[파일:BERT 아키텍처.jpeg]] | [[파일:BERT 아키텍처.jpeg|500px]] | ||

== 특징 == | == 특징 == | ||

2019년 12월 30일 (월) 16:10 판

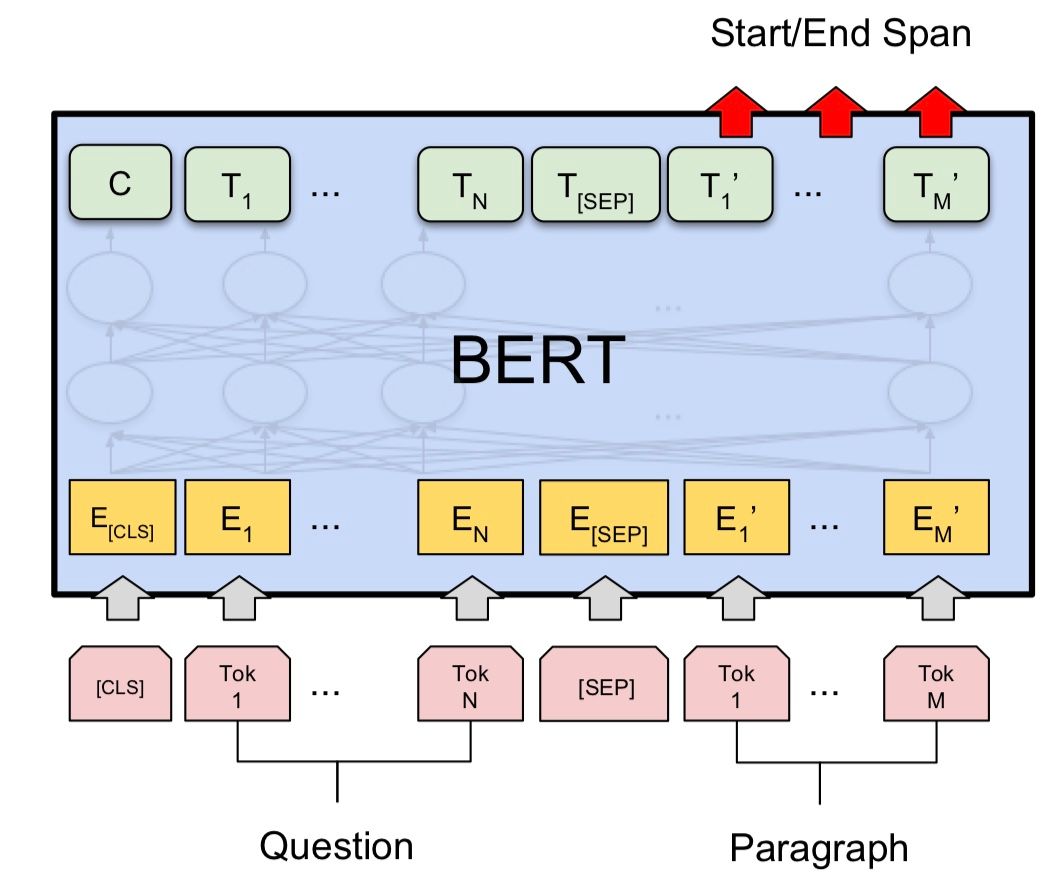

- Bidirectional Encoder Representations from Transformers

- 자연어 처리 언어 모델

특징

- RNN을 사용하지 않는 Attention 모델

- 계산 cost가 매우 큰 모델

주요 기술

- WordPiece tokenizing

- 접두사, 접미사를 구분

- ex) playing, coming, loving → ##ing

- ex) 서울특별시, 세종특별시, 성남시, 안양시 → ##특별시, ##시