파라미터 서버

IT 위키

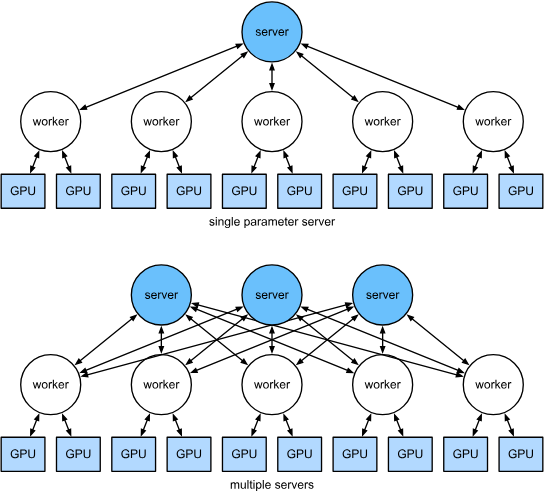

인공무능 (토론 | 기여)님의 2025년 11월 13일 (목) 05:38 판 (새 문서: 섬네일|파라미터 서버(싱글과 멀티 서버 방식) 파라미터 서버(Parameter Server)는 대규모 분산 머신러닝에서 모델 파라미터(가중치)를 관리하고 동기화하기 위해 사용되는 분산 시스템 구조이다. ==개요== 파라미터 서버 아키텍처는 여러 개의 워커(worker) 노드가 각자 데이터 샘플을 사용해 기울기(gradient)를 계산하고, 중앙 또는 분산된 서버(serv...)

파라미터 서버(Parameter Server)는 대규모 분산 머신러닝에서 모델 파라미터(가중치)를 관리하고 동기화하기 위해 사용되는 분산 시스템 구조이다.

개요

파라미터 서버 아키텍처는 여러 개의 워커(worker) 노드가 각자 데이터 샘플을 사용해 기울기(gradient)를 계산하고, 중앙 또는 분산된 서버(server) 노드가 이를 수집·통합해 모델 파라미터를 갱신하는 방식으로 동작한다. 이 구조는 초기 대규모 딥러닝 및 머신러닝 시스템에서 널리 사용되었으며, 특히 비동기식 학습과 대규모 클러스터 환경에서 효과적이었다.

구조

파라미터 서버는 일반적으로 다음과 같은 두 종류의 노드로 구성된다.

- 워커(Worker): 로컬 데이터셋으로 순전파와 역전파를 수행하고 gradient를 계산한다.

- 서버(Server): 워커로부터 전달된 gradient를 집계하고 파라미터를 업데이트한다.

동작 방식

1. 순전파 및 역전파

워커 노드는 주어진 미니배치를 사용하여 모델의 순전파(forward pass)와 역전파(backward pass)를 수행한다.

2. 기울기 전송

각 워커는 계산된 기울기를 파라미터 서버에 전송한다.

3. 파라미터 집계 및 갱신

서버는 여러 워커로부터 전달된 기울기를 집계하고, 이를 바탕으로 모델 파라미터를 갱신한다.

4. 파라미터 배포

갱신된 파라미터는 다시 워커들에게 전달되어 다음 학습 단계에서 사용된다.

동기식과 비동기식 방식

- 동기식(Synchronous): 모든 워커가 기울기 계산을 완료할 때까지 기다린 다음 파라미터를 갱신한다.

- 비동기식(Asynchronous): 워커는 서로 기다리지 않고 계산과 갱신을 독립적으로 진행한다.

비동기식 방식은 학습 속도가 빠르지만, 뒤쳐진 워커가 오래된 파라미터(Stale Parameter)를 사용할 위험이 있다.

장점

- 시스템 일부가 느려도 전체 학습이 중단되지 않는 견고성(fault tolerance).

- 비동기식 학습을 통해 높은 처리량을 얻을 수 있음.

- 초기 분산 머신러닝 환경에서 구현이 상대적으로 단순함.

단점

- 서버 노드에 통신량이 집중되어 병목(bottleneck)이 발생할 수 있다.

- 서버 확장이 어렵기 때문에 매우 큰 규모의 분산 학습에서는 비효율적이다.

- 워커 간 동기화 비용이 증가하면서 전체 학습 성능이 떨어질 수 있다.

발전과 현대적 대안

파라미터 서버는 초기 분산 딥러닝에서 중요한 역할을 했지만, 최근 대규모 딥러닝 모델 학습에서는 All-Reduce 기반 방식이 더 널리 사용된다. Ring All-Reduce와 같은 알고리즘은 통신 부하가 균등하게 분산되므로 확장성이 높아 현대 GPU 클러스터에 적합하다.

같이 보기

참고 문헌

- Li, Mu; Andersen, David G.; Park, Jinwoo et al. "Scaling Distributed Machine Learning with the Parameter Server." OSDI (2014).

- Dean, Jeffrey; Corrado, Greg; Monga, Rajat et al. "Large Scale Distributed Deep Networks." NIPS (2012).