대형 언어 모델 채널별 이상치

대형 언어 모델 채널별 이상치 (Channelwise Outlier in Large Language Models)는 트랜스포머(Transformer) 기반 신경망 내부에서 특정 채널(hidden dimension)들이 다른 채널보다 훨씬 큰 활성값을 갖는 현상을 의미한다. 이러한 현상은 대형 언어 모델(LLM)의 Layer Normalization과 Scaling 과정에서 반복적으로 관찰되며, 수치적 이상치(outlier)라기보다 모델 구조상 필연적으로 발생하는 활성 증폭 효과로 이해되고 있다.[1]

정의[편집 | 원본 편집]

채널별 이상치란 동일한 층(layer)의 여러 채널 중 일부에서, 정규화 이후에도 다른 채널에 비해 훨씬 큰 값을 갖는 활성(activation)이 존재하는 현상을 말한다. 이러한 이상치는 모델 내부의 특정 차원(feature dimension)에서 반복적으로 관찰되며, 출력 분포의 극단값으로 작용해 모델의 표현력과 안정성 모두에 영향을 미칠 수 있다.[2]

형성 과정[편집 | 원본 편집]

채널별 이상치는 주로 Layer Normalization과 Scaling + Bias 단계의 상호작용을 통해 형성된다.[3]

1. 표준화 단계 (Standardization)[편집 | 원본 편집]

Layer Normalization에서는 입력 텐서 X를 채널별 평균(μ)과 표준편차(σ)로 정규화한다.

X' = (X_r - μ_r) / σ_r # for each channel r

- 표준편차 σ가 작은 채널일수록, 정규화 이후 값이 상대적으로 크게 확대되어 outlier 채널로 나타난다.*

- 즉, "When the standard deviation is low, channel-wise outliers become more pronounced."*

2. 스케일링 및 바이어스 단계 (Scaling + Bias)[편집 | 원본 편집]

정규화된 출력 X'에 대해 학습 가능한 파라미터 α(스케일)와 β(바이어스)가 적용된다.

Y_e = α_e * X'_e + β_e # for each channel e

- 일부 채널에서 α가 과도하게 크거나 β가 비정상적으로 이동하면, 해당 채널의 출력이 다시 증폭되어 outlier로 형성된다.

- CLIP, LLaMA, OPT 등 다양한 모델에서 α, β의 특정 차원이 두드러진 스파이크 형태로 관찰된다.

3. 잔차 연결 (Residual Connection)[편집 | 원본 편집]

- Transformer 구조에서 residual stream은 이전 층의 출력을 그대로 더하기 때문에, 한 번 발생한 채널별 이상치가 다음 층으로 전달되어 유지된다.

- 이러한 누적 효과로 인해, 동일한 차원에서 반복적인 outlier 패턴이 나타난다.

특징[편집 | 원본 편집]

- 반복적 위치성 — 특정 차원(예: LLaMA2-7B의 1415, 2533번 차원 등)에서 지속적으로 발생한다.[2]

- 입력 무관성 — 입력 토큰과 무관하게 유지되는 상수형 활성값을 보이기도 한다.

- Residual Stream 유지 — 각 층의 W_out 변환을 통해 다음 층으로 outlier가 전달된다.

- LayerNorm 의존성 — BatchNorm에서는 덜하지만, LayerNorm에서는 매우 강하게 나타난다.

발생 원인 요약[편집 | 원본 편집]

| 단계 | 주요 원인 | 설명 |

|---|---|---|

| 표준화 단계 | σ가 작은 채널 | 정규화로 인해 작은 분산이 큰 값으로 확대됨 |

| 스케일링 단계 | γ(α), β 편향 | 특정 채널의 스케일링 파라미터가 과도하게 큼 |

| 잔차 연결 | W_out 중복 전달 | 이전 층의 이상치가 그대로 누적됨 |

| 구조적 특성 | 채널 독립 정규화 | LayerNorm의 per-channel 독립성으로 보정 불가 |

시각적 관찰[편집 | 원본 편집]

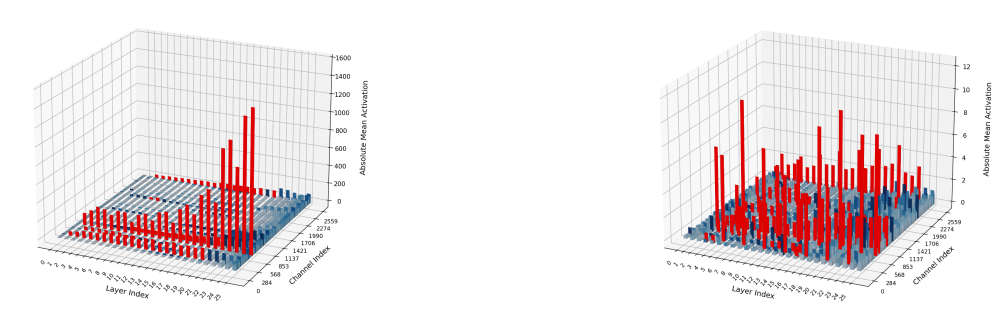

채널별 이상치는 3D 활성 분포 그래프에서 특정 차원의 활성값이 수직으로 솟아오른 형태로 관찰된다.

CLIP 및 OPT 모델의 실험에서는 Layer 6~12 구간에서 이러한 패턴이 두드러지게 나타났다.

# 예시: CLIP의 Layer 12 bias/scale 프로파일

ln_weight_layer12 = [ ... spikes at channel 420, 880 ... ]

ln_bias_layer12 = [ ... spikes at channel 420 ... ]

영향[편집 | 원본 편집]

장점[편집 | 원본 편집]

- 일부 연구에서는 채널별 이상치가 attention 집중 및 표현 압축에 기여한다고 본다.

- 특정 차원의 bias-like 효과로 인해 모델의 안정성을 높이는 역할을 할 수도 있다.

단점[편집 | 원본 편집]

- 수치적 불안정성(overflow) 및 훈련 불균형을 유발한다.

- 양자화(Quantization) 시 outlier 값이 성능 저하의 주요 원인이 된다.

- pruning, sparsity 등과의 상호작용이 복잡해진다.

관련 연구[편집 | 원본 편집]

- Sun et al. (2024) — Massive Activation에서 일부 차원이 과도하게 활성화됨을 보고.

- Raman et al. (2025) — Residual link를 통해 outlier가 누적된다고 분석.

- Hidden Dynamics (2025) — 훈련 중 outlier 형성의 동역학을 추적.

- CLIP Profiling (2025) — Scaling/Bias 계수가 outlier 형성에 기여함을 실험적으로 제시.

한계 및 향후 연구[편집 | 원본 편집]

- 채널별 이상치의 근본적인 원인은 아직 완전히 규명되지 않았다.

- σ, γ, β의 상호작용을 설명하는 정량적 수식 모델이 요구된다.

- Residual stream을 통한 outlier 재활성화(recycling) 방지 전략 연구가 필요하다.

- LayerNorm 구조를 수정한 대체 정규화 기법(GroupNorm, RMSNorm 등)에 대한 비교 연구가 진행 중이다.

같이 보기[편집 | 원본 편집]

참고 문헌[편집 | 원본 편집]

- Sun, Mingjie et al. “Massive Activations in Large Language Models.” arXiv, 2024.

- Raman, Rahul et al. “Rethinking the Outlier Distribution in Large Language Models.” arXiv, 2025.

- Hidden Dynamics of Massive Activations in Transformer, arXiv, 2025.

- Channelwise Outlier Profiling on CLIP, arXiv, 2025.