역전파

IT 위키

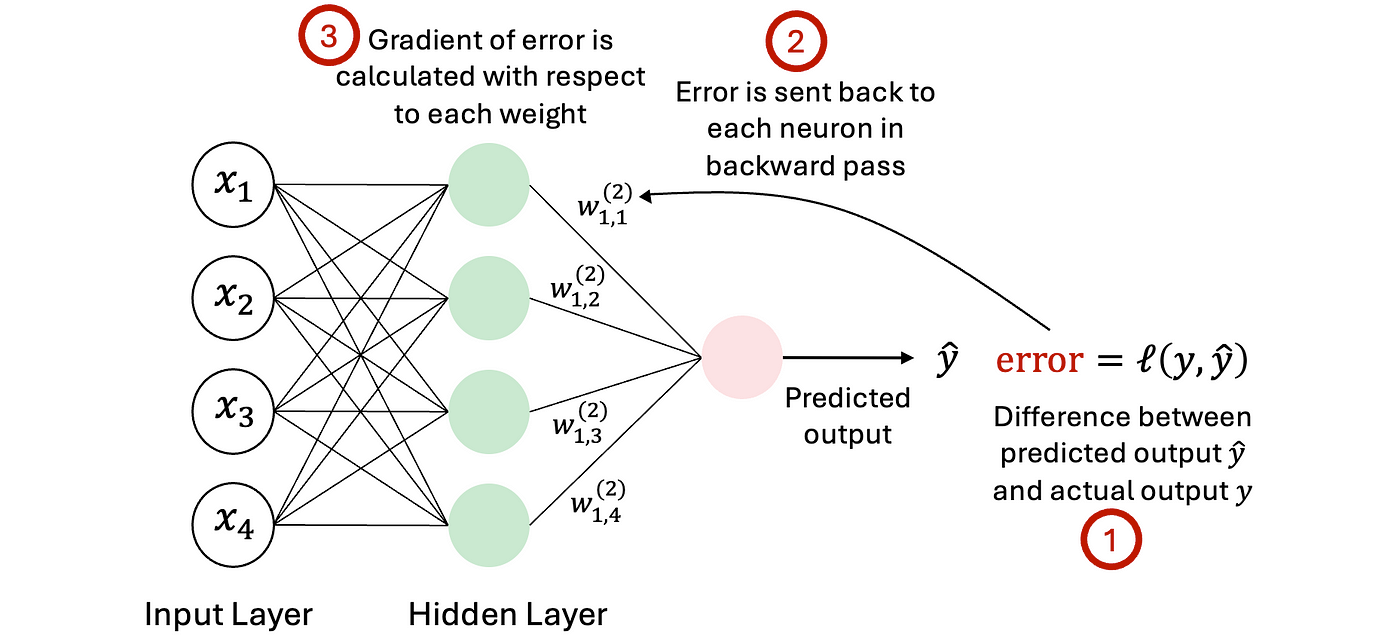

역전파(Backpropagation)은 인공신경망에서 학습을 위해 오차를 출력층에서 입력층 방향으로 전파시키며 가중치를 조정하는 알고리즘이다.

개요[편집 | 원본 편집]

역전파는 다층 퍼셉트론(Multilayer Perceptron, MLP) 등의 인공신경망이 주어진 입력에 대해 예측을 수행한 후, 실제 값과의 오차를 기반으로 각 층의 가중치를 효율적으로 업데이트하기 위해 사용된다. 이는 경사하강법(gradient descent)과 연계되어 손실 함수를 최소화하는 방향으로 가중치를 조정한다.

작동 원리[편집 | 원본 편집]

- 1. 순전파: 입력 데이터를 받아 각 층을 통과시키며 예측값을 계산한다.

- 2. 손실 계산: 예측값과 실제값의 차이를 손실 함수로 계산한다.

- 3. 역전파: 연쇄 법칙(chain rule)을 사용하여 손실 함수의 기울기를 출력층에서부터 입력층 방향으로 계산한다.

- 4. 가중치 업데이트: 계산된 기울기를 바탕으로 각 층의 가중치를 조정한다.

수학적 설명[편집 | 원본 편집]

오차 함수 E를 각 가중치 w에 대해 미분하여, E를 w에 대한 편미분값으로 나타낸다. 이를 바탕으로 다음과 같이 가중치를 갱신한다.

w = w - 학습률 × 오차 함수의 기울기

여기서 학습률은 가중치를 얼마나 빠르게 조정할지를 결정하는 하이퍼파라미터이다.

중요성[편집 | 원본 편집]

역전파 알고리즘은 딥러닝의 발전을 가능하게 한 핵심 기술 중 하나로, 다층 구조를 가진 신경망이 효과적으로 학습할 수 있게 해준다. 1986년 Rumelhart, Hinton, Williams의 논문을 통해 대중화되었으며, 이후 CNN, RNN 등 다양한 신경망 구조에 응용되고 있다.

한계점 및 극복 방안[편집 | 원본 편집]

- 한계점

- 기울기 소실 또는 폭주 문제

- 과적합 가능성

- 극복 방안

- ReLU 등의 적절한 활성화 함수 사용

- 드롭아웃, 배치 정규화 등 정규화 기법 활용

- 가중치 초기화 전략과 최적화 알고리즘 개선

같이 보기[편집 | 원본 편집]

참고 문헌[편집 | 원본 편집]

- Rumelhart, D. E., Hinton, G. E., & Williams, R. J. (1986). "Learning representations by back-propagating errors". Nature, 323(6088), 533-536.