셀프 어텐션: 두 판 사이의 차이

IT 위키

(새 문서: 셀프 어탠션(Self-Attention)은 딥러닝에서 입력 시퀀스의 각 요소가 동일 시퀀스 내 다른 요소들과 어떤 관계를 갖는지를 스스로 학습하는 어탠션(Attention) 메커니즘의 한 종류이다. 문장 내 단어들 간 상호 연관성을 반영하여 문맥 정보를 효과적으로 포착할 수 있게 하며, 트랜스포머(Transformer) 구조의 핵심 구성 요소이다. ==개요== 셀프 어탠션은 주어진 입력 시퀀스 전...) |

편집 요약 없음 |

||

| 1번째 줄: | 1번째 줄: | ||

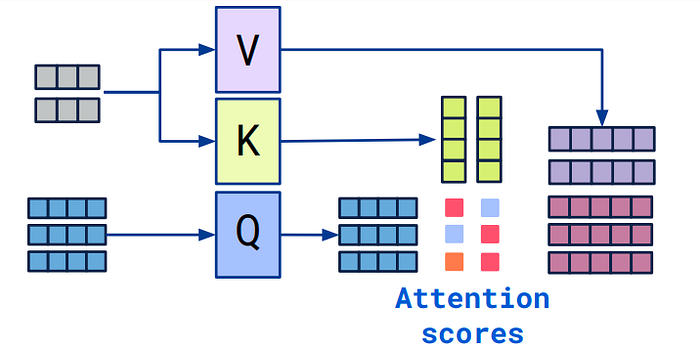

셀프 | [[파일:어텐션 메커니즘.png|섬네일|어텐션 메커니즘]] | ||

셀프 어텐션(Self-Attention)은 딥러닝에서 입력 시퀀스의 각 요소가 동일 시퀀스 내 다른 요소들과 어떤 관계를 갖는지를 스스로 학습하는 어텐션(Attention) 메커니즘의 한 종류이다. 문장 내 단어들 간 상호 연관성을 반영하여 문맥 정보를 효과적으로 포착할 수 있게 하며, 트랜스포머(Transformer) 구조의 핵심 구성 요소이다. | |||

==개요== | ==개요== | ||

셀프 | 셀프 어텐션은 주어진 입력 시퀀스 전체를 한 번에 고려하여 각 토큰 간 상호작용을 계산한다. 이를 통해 순차적 처리 방식([[RNN]] 등) 없이도 각 위치의 토큰이 문맥 내 다른 모든 토큰과 정보를 주고받을 수 있다. 트랜스포머의 인코더와 디코더 내부의 어텐션 계층은 모두 셀프 어텐션으로 구성되어 있으며, 자연어 처리, 컴퓨터 비전 등 다양한 분야에서 활용된다. | ||

==동작 방식== | ==동작 방식== | ||

셀프 | 셀프 어텐션은 입력 시퀀스의 각 토큰을 Query, Key, Value라는 세 가지 벡터로 변환한 뒤, Query와 Key 사이의 유사도를 계산하여 Softmax 함수를 통해 가중치(중요도)를 구한다. 이 가중치를 Value 벡터에 곱한 후 합산하면, 문맥을 반영한 새로운 토큰 표현이 생성된다. | ||

이 과정을 통해 각 단어는 문장 내 다른 단어들과의 의미적 관계를 반영한 벡터로 표현된다. | 이 과정을 통해 각 단어는 문장 내 다른 단어들과의 의미적 관계를 반영한 벡터로 표현된다. | ||

== | ==어텐션과의 차이== | ||

셀프 | 셀프 어텐션은 어텐션 메커니즘의 하위 개념으로, 입력과 참조 대상이 동일한 경우를 의미한다. 반면, 일반적인 어텐션은 질문(Query)과 문서(Key, Value)처럼 서로 다른 두 시퀀스 간의 연관성을 계산할 수 있다. | ||

==특징== | ==특징== | ||

*병렬 연산이 가능하여 학습 속도가 빠름 | *병렬 연산이 가능하여 학습 속도가 빠름 | ||

| 14번째 줄: | 15번째 줄: | ||

*다양한 입력 형식(텍스트, 이미지 등)에 적용 가능 | *다양한 입력 형식(텍스트, 이미지 등)에 적용 가능 | ||

==활용== | ==활용== | ||

*트랜스포머 기반 언어 모델(BERT, GPT 등)의 핵심 연산 | *트랜스포머 기반 언어 모델([[BERT]], GPT 등)의 핵심 연산 | ||

*기계 번역, 요약, 질의응답, 문장 분류 등의 NLP 작업 | *기계 번역, 요약, 질의응답, 문장 분류 등의 NLP 작업 | ||

*비전 트랜스포머(ViT)를 통한 이미지 분석 | *비전 트랜스포머(ViT)를 통한 이미지 분석 | ||

*멀티모달 모델에서 텍스트와 이미지 간 상호작용 학습 | *멀티모달 모델에서 텍스트와 이미지 간 상호작용 학습 | ||

==같이 보기== | ==같이 보기== | ||

*[[어탠션 (인공지능)]] | *[[어탠션 (인공지능)|어텐션 (인공지능)]] | ||

*[[트랜스포머 (인공지능)]] | *[[트랜스포머 (인공지능)]] | ||

*[[BERT]] | *[[BERT]] | ||

| 28번째 줄: | 29번째 줄: | ||

==각주== | ==각주== | ||

[[분류:인공지능]] | [[분류:인공지능]] | ||

[[분류: | [[분류:자연어 처리]] | ||

2025년 9월 24일 (수) 11:09 기준 최신판

셀프 어텐션(Self-Attention)은 딥러닝에서 입력 시퀀스의 각 요소가 동일 시퀀스 내 다른 요소들과 어떤 관계를 갖는지를 스스로 학습하는 어텐션(Attention) 메커니즘의 한 종류이다. 문장 내 단어들 간 상호 연관성을 반영하여 문맥 정보를 효과적으로 포착할 수 있게 하며, 트랜스포머(Transformer) 구조의 핵심 구성 요소이다.

개요[편집 | 원본 편집]

셀프 어텐션은 주어진 입력 시퀀스 전체를 한 번에 고려하여 각 토큰 간 상호작용을 계산한다. 이를 통해 순차적 처리 방식(RNN 등) 없이도 각 위치의 토큰이 문맥 내 다른 모든 토큰과 정보를 주고받을 수 있다. 트랜스포머의 인코더와 디코더 내부의 어텐션 계층은 모두 셀프 어텐션으로 구성되어 있으며, 자연어 처리, 컴퓨터 비전 등 다양한 분야에서 활용된다.

동작 방식[편집 | 원본 편집]

셀프 어텐션은 입력 시퀀스의 각 토큰을 Query, Key, Value라는 세 가지 벡터로 변환한 뒤, Query와 Key 사이의 유사도를 계산하여 Softmax 함수를 통해 가중치(중요도)를 구한다. 이 가중치를 Value 벡터에 곱한 후 합산하면, 문맥을 반영한 새로운 토큰 표현이 생성된다.

이 과정을 통해 각 단어는 문장 내 다른 단어들과의 의미적 관계를 반영한 벡터로 표현된다.

어텐션과의 차이[편집 | 원본 편집]

셀프 어텐션은 어텐션 메커니즘의 하위 개념으로, 입력과 참조 대상이 동일한 경우를 의미한다. 반면, 일반적인 어텐션은 질문(Query)과 문서(Key, Value)처럼 서로 다른 두 시퀀스 간의 연관성을 계산할 수 있다.

특징[편집 | 원본 편집]

- 병렬 연산이 가능하여 학습 속도가 빠름

- 문장 내 장거리 의존성(long-range dependency)을 효과적으로 학습

- 시각화를 통해 모델이 주목하는 단어를 해석할 수 있음

- 다양한 입력 형식(텍스트, 이미지 등)에 적용 가능

활용[편집 | 원본 편집]

- 트랜스포머 기반 언어 모델(BERT, GPT 등)의 핵심 연산

- 기계 번역, 요약, 질의응답, 문장 분류 등의 NLP 작업

- 비전 트랜스포머(ViT)를 통한 이미지 분석

- 멀티모달 모델에서 텍스트와 이미지 간 상호작용 학습

같이 보기[편집 | 원본 편집]

참고 문헌[편집 | 원본 편집]

- Vaswani, A. et al. (2017). "Attention is All You Need". NeurIPS 2017.