Mixture of Experts (인공지능)

Mixture of Experts(줄여서 MoE)는 여러 개의 전문가 모델(expert model)과 게이트(gating) 또는 라우터(router) 메커니즘을 결합하여 입력에 따라 적절한 전문가를 선택하거나 가중합하여 출력을 내는 기계학습 기법이다. 주로 딥러닝에서 모델의 효율적 확장과 성능 향상을 위해 사용된다.

개요

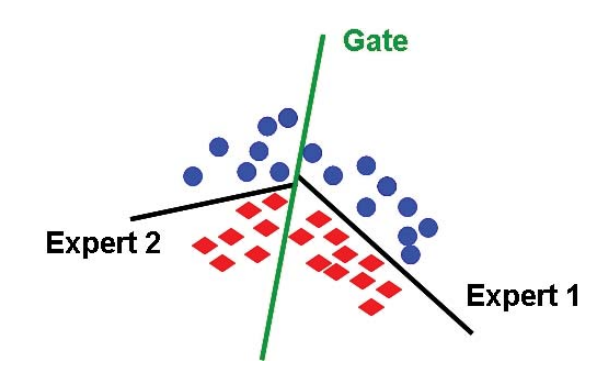

Mixture of Experts는 입력 공간을 분할하여 각 부분에 대해 특화된 모델이 학습되도록 하고, 게이트 네트워크(또는 라우터)가 입력에 따라 어떤 전문가의 출력을 사용할지를 결정한다. 이를 통해 하나의 복잡한 모델 대신 여러 개의 단순한 전문가 모델을 결합하여 높은 표현력을 얻을 수 있다.

역사

Mixture of Experts 개념은 1990년대 초반 제이콥스(R. Jacobs), 조던(M. Jordan), 힌튼(G. Hinton) 등이 제안한 연구에서 처음 체계화되었다. 당시에는 여러 작은 신경망을 결합하여 입력 공간을 분할 학습하는 방식으로 활용되었으나, 연산 자원과 데이터의 한계로 널리 확산되지는 못했다.

2010년대 후반, 구글 브레인의 GShard, Switch Transformer와 같은 연구에서 MoE가 대규모 신경망을 효율적으로 확장하는 방법으로 다시 주목받기 시작했다. 특히 샤지어(Shazeer) 등이 2017년에 발표한 Sparsely-Gated Mixture-of-Experts Layer는 MoE의 현대적 응용을 여는 계기가 되었다.

2020년대 들어서는 초거대 언어 모델(LLM)의 학습과 서비스에서 MoE가 핵심 구조로 자리 잡았다.

- 중국의 DeepSeek 시리즈는 MoE 아키텍처를 상업적으로 적극 활용하며, 대규모 모델을 상대적으로 저렴한 비용으로 학습할 수 있음을 보여주어 국제적 주목을 받았다.

- OpenAI의 GPT-5 역시 내부적으로 MoE 구조를 사용한 것으로 알려져 있으며, 초기 공개 당시 라우터(router) 문제로 성능 저하가 발생했다는 사실이 샘 알트만의 발언을 통해 언론에 보도되기도 했다.[1][2]

이처럼 MoE는 연구적 맥락에서 시작하여, 현재는 대규모 상용 AI 모델에서 계산 효율성과 성능을 동시에 달성하기 위한 주요 방법론으로 자리매김하고 있다.

구조

- 전문가(Expert)

- 특정 부분 문제를 해결하도록 학습된 개별 모델. 보통 신경망이 사용된다.

- 게이트(Gate) 또는 라우터(Router)

- 입력을 받아 각 전문가의 가중치 또는 선택 결과를 산출하는 모듈.

- 소프트맥스 함수 등을 사용하여 확률 분포 형태로 출력하거나, 소수의 전문가만 활성화하는 스파스 방식으로 동작할 수 있다.

- 출력 결합

- 전문가들의 출력을 게이트/라우터가 부여한 가중치로 합산하거나 선택하여 최종 출력을 만든다.

학습

학습 과정에서 게이트(라우터)와 전문가 모델은 동시에 최적화된다. 보통 경사하강법과 역전파가 사용되며, 게이트는 입력 분배를, 전문가는 해당 입력에 대한 적합한 출력을 학습한다.

변형

- 하드 게이팅(hard gating)

- 하나의 전문가만을 선택하여 출력을 사용하는 방식.

- 소프트 게이팅(soft gating)

- 여러 전문가 출력을 가중합하여 사용하는 방식.

- 스파스 MoE(Sparse Mixture of Experts)

- 모든 전문가를 사용하는 대신 소수만 활성화하여 계산 효율을 높이는 방식. 대규모 언어 모델에서 널리 사용된다.

응용

- 대규모 언어 모델(LLM)에서 파라미터 수를 늘리면서도 계산 효율을 유지하기 위해 사용된다.

- 컴퓨터 비전, 음성 인식 등 복잡한 입력 분포를 가진 분야에서 효과적이다.

- 멀티태스크 학습에서 서로 다른 작업에 특화된 전문가를 학습시키는 데 활용된다.

같이 보기

참고 문헌

- Jacobs, R. A., Jordan, M. I., Nowlan, S. J., & Hinton, G. E. (1991). Adaptive mixtures of local experts. Neural Computation, 3(1), 79-87.

- Shazeer, N. et al. (2017). Outrageously Large Neural Networks: The Sparsely-Gated Mixture-of-Experts Layer. arXiv:1701.06538.